Definieren, ob Claude für Ticket-Routing verwendet werden soll

Hier sind einige wichtige Indikatoren, dass Sie ein LLM wie Claude anstelle traditioneller ML-Ansätze für Ihre Klassifizierungsaufgabe verwenden sollten:Sie haben begrenzte gelabelte Trainingsdaten verfügbar

Sie haben begrenzte gelabelte Trainingsdaten verfügbar

Ihre Klassifizierungskategorien werden sich wahrscheinlich ändern oder im Laufe der Zeit entwickeln

Ihre Klassifizierungskategorien werden sich wahrscheinlich ändern oder im Laufe der Zeit entwickeln

Sie müssen komplexe, unstrukturierte Texteingaben verarbeiten

Sie müssen komplexe, unstrukturierte Texteingaben verarbeiten

Ihre Klassifizierungsregeln basieren auf semantischem Verständnis

Ihre Klassifizierungsregeln basieren auf semantischem Verständnis

Sie benötigen interpretierbare Begründungen für Klassifizierungsentscheidungen

Sie benötigen interpretierbare Begründungen für Klassifizierungsentscheidungen

Sie möchten Grenzfälle und mehrdeutige Tickets effektiver handhaben

Sie möchten Grenzfälle und mehrdeutige Tickets effektiver handhaben

Sie benötigen mehrsprachige Unterstützung ohne separate Modelle zu pflegen

Sie benötigen mehrsprachige Unterstützung ohne separate Modelle zu pflegen

Erstellen und Bereitstellen Ihres LLM-Support-Workflows

Verstehen Sie Ihren aktuellen Support-Ansatz

Bevor Sie sich in die Automatisierung stürzen, ist es entscheidend, Ihr bestehendes Ticketing-System zu verstehen. Beginnen Sie damit, zu untersuchen, wie Ihr Support-Team derzeit Ticket-Routing handhabt. Betrachten Sie Fragen wie:- Welche Kriterien werden verwendet, um zu bestimmen, welches SLA/Serviceangebot angewendet wird?

- Wird Ticket-Routing verwendet, um zu bestimmen, zu welcher Support-Stufe oder welchem Produktspezialisten ein Ticket geht?

- Gibt es bereits automatisierte Regeln oder Workflows? In welchen Fällen versagen sie?

- Wie werden Grenzfälle oder mehrdeutige Tickets behandelt?

- Wie priorisiert das Team Tickets?

Definieren Sie Benutzerabsichtskategorien

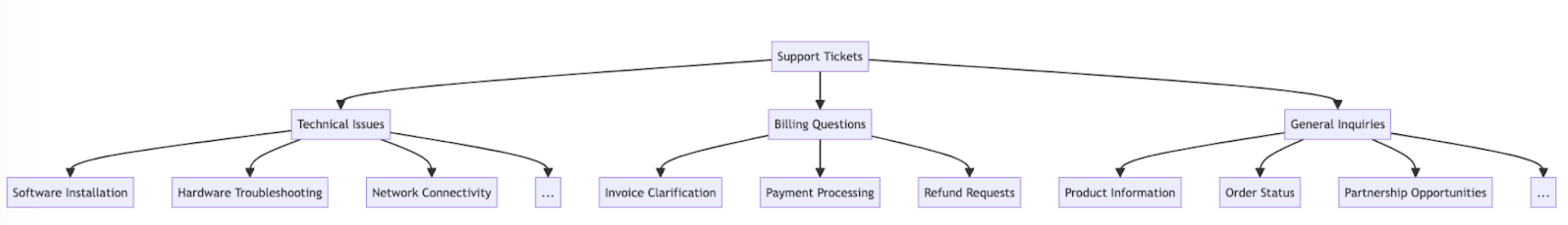

Eine gut definierte Liste von Benutzerabsichtskategorien ist entscheidend für eine genaue Support-Ticket-Klassifizierung mit Claude. Claudes Fähigkeit, Tickets effektiv in Ihrem System zu routen, ist direkt proportional dazu, wie gut definiert die Kategorien Ihres Systems sind. Hier sind einige Beispiele für Benutzerabsichtskategorien und Unterkategorien.Technisches Problem

Technisches Problem

- Hardware-Problem

- Software-Bug

- Kompatibilitätsproblem

- Leistungsproblem

Kontoverwaltung

Kontoverwaltung

- Passwort zurücksetzen

- Kontozugriffsprobleme

- Rechnungsanfragen

- Abonnement-Änderungen

Produktinformationen

Produktinformationen

- Feature-Anfragen

- Produktkompatibilitätsfragen

- Preisinformationen

- Verfügbarkeitsanfragen

Benutzerführung

Benutzerführung

- Anleitungsfragen

- Feature-Nutzungshilfe

- Best-Practice-Beratung

- Fehlerbehebungsanleitung

Feedback

Feedback

- Bug-Berichte

- Feature-Anfragen

- Allgemeines Feedback oder Vorschläge

- Beschwerden

Bestellbezogen

Bestellbezogen

- Bestellstatusanfragen

- Versandinformationen

- Rücksendungen und Umtausch

- Bestelländerungen

Service-Anfrage

Service-Anfrage

- Installationshilfe

- Upgrade-Anfragen

- Wartungsplanung

- Service-Kündigung

Sicherheitsbedenken

Sicherheitsbedenken

- Datenschutzanfragen

- Berichte über verdächtige Aktivitäten

- Sicherheitsfeature-Hilfe

Compliance und Recht

Compliance und Recht

- Regulatorische Compliance-Fragen

- Nutzungsbedingungsanfragen

- Rechtsdokumentationsanfragen

Notfall-Support

Notfall-Support

- Kritische Systemausfälle

- Dringende Sicherheitsprobleme

- Zeitkritische Probleme

Schulung und Bildung

Schulung und Bildung

- Produktschulungsanfragen

- Dokumentationsanfragen

- Webinar- oder Workshop-Informationen

Integration und API

Integration und API

- Integrationshilfe

- API-Nutzungsfragen

- Drittanbieter-Kompatibilitätsanfragen

Erfolgskriterien festlegen

Arbeiten Sie mit Ihrem Support-Team zusammen, um klare Erfolgskriterien zu definieren mit messbaren Benchmarks, Schwellenwerten und Zielen. Hier sind einige Standardkriterien und Benchmarks bei der Verwendung von LLMs für Support-Ticket-Routing:Klassifizierungskonsistenz

Klassifizierungskonsistenz

Anpassungsgeschwindigkeit

Anpassungsgeschwindigkeit

Mehrsprachige Handhabung

Mehrsprachige Handhabung

Grenzfall-Handhabung

Grenzfall-Handhabung

Bias-Minderung

Bias-Minderung

Prompt-Effizienz

Prompt-Effizienz

Erklärbarkeits-Score

Erklärbarkeits-Score

Routing-Genauigkeit

Routing-Genauigkeit

Zeit bis zur Zuweisung

Zeit bis zur Zuweisung

Umleitungsrate

Umleitungsrate

Erstkontakt-Lösungsrate

Erstkontakt-Lösungsrate

Durchschnittliche Bearbeitungszeit

Durchschnittliche Bearbeitungszeit

Kundenzufriedenheitswerte

Kundenzufriedenheitswerte

Eskalationsrate

Eskalationsrate

Agent-Produktivität

Agent-Produktivität

Self-Service-Ablenkungsrate

Self-Service-Ablenkungsrate

Kosten pro Ticket

Kosten pro Ticket

Das richtige Claude-Modell wählen

Die Wahl des Modells hängt von den Kompromissen zwischen Kosten, Genauigkeit und Antwortzeit ab. Viele Kunden habenclaude-3-5-haiku-20241022 als ideales Modell für Ticket-Routing empfunden, da es das schnellste und kosteneffektivste Modell in der Claude 3-Familie ist und dennoch hervorragende Ergebnisse liefert. Wenn Ihr Klassifizierungsproblem tiefes Fachwissen oder eine große Anzahl von Absichtskategorien mit komplexer Argumentation erfordert, können Sie sich für das größere Sonnet-Modell entscheiden.

Einen starken Prompt erstellen

Ticket-Routing ist eine Art von Klassifizierungsaufgabe. Claude analysiert den Inhalt eines Support-Tickets und klassifiziert es in vordefinierte Kategorien basierend auf dem Problemtyp, der Dringlichkeit, der erforderlichen Expertise oder anderen relevanten Faktoren. Lassen Sie uns einen Ticket-Klassifizierungs-Prompt schreiben. Unser anfänglicher Prompt sollte den Inhalt der Benutzeranfrage enthalten und sowohl die Begründung als auch die Absicht zurückgeben.- Wir verwenden Python f-Strings, um die Prompt-Vorlage zu erstellen, wodurch der

ticket_contentsin die<request>-Tags eingefügt werden kann. - Wir geben Claude eine klar definierte Rolle als Klassifizierungssystem, das den Ticket-Inhalt sorgfältig analysiert, um die Kernabsicht und Bedürfnisse des Kunden zu bestimmen.

- Wir weisen Claude zur ordnungsgemäßen Ausgabeformatierung an, in diesem Fall seine Begründung und Analyse in

<reasoning>-Tags zu liefern, gefolgt vom entsprechenden Klassifizierungslabel in<intent>-Tags. - Wir spezifizieren die gültigen Absichtskategorien: “Support, Feedback, Beschwerde”, “Bestellverfolgung” und “Rückerstattung/Umtausch”.

- Wir fügen einige Beispiele hinzu (auch bekannt als Few-Shot-Prompting), um zu veranschaulichen, wie die Ausgabe formatiert werden sollte, was Genauigkeit und Konsistenz verbessert.

Ihren Prompt bereitstellen

Es ist schwer zu wissen, wie gut Ihr Prompt funktioniert, ohne ihn in einer Test-Produktionsumgebung bereitzustellen und Evaluierungen durchzuführen. Lassen Sie uns die Bereitstellungsstruktur aufbauen. Beginnen Sie damit, die Methodensignatur für das Umhüllen unseres Aufrufs an Claude zu definieren. Wir nehmen die Methode, die wir bereits zu schreiben begonnen haben, dieticket_contents als Eingabe hat, und geben nun ein Tupel von reasoning und intent als Ausgabe zurück. Wenn Sie eine bestehende Automatisierung mit traditionellem ML haben, sollten Sie stattdessen dieser Methodensignatur folgen.

- Importiert die Anthropic-Bibliothek und erstellt eine Client-Instanz mit Ihrem API-Schlüssel.

- Definiert eine

classify_support_request-Funktion, die einenticket_contents-String nimmt. - Sendet den

ticket_contentszur Klassifizierung mit demclassification_promptan Claude - Gibt die

reasoningundintentdes Modells zurück, die aus der Antwort extrahiert wurden.

stream=False (der Standard).

Evaluieren Sie Ihren Prompt

Prompting erfordert oft Tests und Optimierung, um produktionsreif zu sein. Um die Bereitschaft Ihrer Lösung zu bestimmen, bewerten Sie die Leistung basierend auf den Erfolgskriterien und Schwellenwerten, die Sie zuvor festgelegt haben. Um Ihre Evaluierung durchzuführen, benötigen Sie Testfälle, auf denen Sie sie ausführen können. Der Rest dieses Leitfadens geht davon aus, dass Sie bereits Ihre Testfälle entwickelt haben.Eine Evaluierungsfunktion erstellen

Unsere Beispiel-Evaluierung für diesen Leitfaden misst Claudes Leistung entlang drei Schlüsselmetriken:- Genauigkeit

- Kosten pro Klassifizierung

- Wir haben die

actual_intentaus unseren Testfällen in dieclassify_support_request-Methode hinzugefügt und einen Vergleich eingerichtet, um zu bewerten, ob Claudes Absichtsklassifizierung mit unserer goldenen Absichtsklassifizierung übereinstimmt. - Wir haben Nutzungsstatistiken für den API-Aufruf extrahiert, um Kosten basierend auf verwendeten Eingabe- und Ausgabe-Tokens zu berechnen

Ihre Evaluierung durchführen

Eine ordnungsgemäße Evaluierung erfordert klare Schwellenwerte und Benchmarks, um zu bestimmen, was ein gutes Ergebnis ist. Das obige Skript gibt uns die Laufzeitwerte für Genauigkeit, Antwortzeit und Kosten pro Klassifizierung, aber wir bräuchten immer noch klar etablierte Schwellenwerte. Zum Beispiel:- Genauigkeit: 95% (von 100 Tests)

- Kosten pro Klassifizierung: 50% Reduzierung im Durchschnitt (über 100 Tests) von der aktuellen Routing-Methode

Leistung verbessern

In komplexen Szenarien kann es hilfreich sein, zusätzliche Strategien zur Leistungsverbesserung über Standard-Prompt-Engineering-Techniken und Guardrail-Implementierungsstrategien hinaus zu betrachten. Hier sind einige häufige Szenarien:Verwenden Sie eine taxonomische Hierarchie für Fälle mit 20+ Absichtskategorien

Wenn die Anzahl der Klassen wächst, erweitert sich auch die Anzahl der erforderlichen Beispiele, wodurch der Prompt möglicherweise unhandlich wird. Als Alternative können Sie die Implementierung eines hierarchischen Klassifizierungssystems mit einer Mischung von Klassifizierern in Betracht ziehen.- Organisieren Sie Ihre Absichten in einer taxonomischen Baumstruktur.

- Erstellen Sie eine Reihe von Klassifizierern auf jeder Ebene des Baums, wodurch ein kaskadierender Routing-Ansatz ermöglicht wird.

- Vorteile - größere Nuance und Genauigkeit: Sie können verschiedene Prompts für jeden übergeordneten Pfad erstellen, was eine gezieltere und kontextspezifischere Klassifizierung ermöglicht. Dies kann zu verbesserter Genauigkeit und nuancierterem Umgang mit Kundenanfragen führen.

- Nachteile - erhöhte Latenz: Beachten Sie, dass mehrere Klassifizierer zu erhöhter Latenz führen können, und wir empfehlen, diesen Ansatz mit unserem schnellsten Modell, Haiku, zu implementieren.

Verwenden Sie Vektordatenbanken und Ähnlichkeitssuche-Retrieval für hochvariable Tickets

Obwohl das Bereitstellen von Beispielen der effektivste Weg zur Leistungsverbesserung ist, kann es schwierig sein, genügend Beispiele in einem einzigen Prompt einzuschließen, wenn Support-Anfragen hochvariabel sind. In diesem Szenario könnten Sie eine Vektordatenbank verwenden, um Ähnlichkeitssuchen aus einem Datensatz von Beispielen durchzuführen und die relevantesten Beispiele für eine gegebene Abfrage abzurufen. Dieser Ansatz, der detailliert in unserem Klassifizierungs-Rezept beschrieben wird, hat gezeigt, dass er die Leistung von 71% Genauigkeit auf 93% Genauigkeit verbessert.Berücksichtigen Sie spezifisch erwartete Grenzfälle

Hier sind einige Szenarien, in denen Claude Tickets möglicherweise falsch klassifiziert (es kann andere geben, die für Ihre Situation einzigartig sind). In diesen Szenarien sollten Sie explizite Anweisungen oder Beispiele im Prompt bereitstellen, wie Claude den Grenzfall handhaben sollte:Kunden stellen implizite Anfragen

Kunden stellen implizite Anfragen

- Lösung: Geben Sie Claude einige echte Kundenbeispiele dieser Art von Anfragen zusammen mit der zugrundeliegenden Absicht. Sie können noch bessere Ergebnisse erzielen, wenn Sie eine Klassifizierungsbegründung für besonders nuancierte Ticket-Absichten einschließen, damit Claude die Logik besser auf andere Tickets verallgemeinern kann.

Claude priorisiert Emotion über Absicht

Claude priorisiert Emotion über Absicht

- Lösung: Geben Sie Claude Anweisungen, wann Kundenstimmung priorisiert werden soll oder nicht. Es kann so einfach sein wie “Ignorieren Sie alle Kundenemotionen. Konzentrieren Sie sich nur auf die Analyse der Absicht der Kundenanfrage und welche Informationen der Kunde möglicherweise sucht.”

Mehrere Probleme verursachen Verwirrung bei der Problempriorisierung

Mehrere Probleme verursachen Verwirrung bei der Problempriorisierung

- Lösung: Klären Sie die Priorisierung von Absichten, damit Claude die extrahierten Absichten besser bewerten und das Hauptanliegen identifizieren kann.

Claude in Ihren größeren Support-Workflow integrieren

Eine ordnungsgemäße Integration erfordert, dass Sie einige Entscheidungen darüber treffen, wie Ihr Claude-basiertes Ticket-Routing-Skript in die Architektur Ihres größeren Ticket-Routing-Systems passt. Es gibt zwei Möglichkeiten, wie Sie dies tun könnten:- Push-basiert: Das Support-Ticket-System, das Sie verwenden (z.B. Zendesk), löst Ihren Code aus, indem es ein Webhook-Event an Ihren Routing-Service sendet, der dann die Absicht klassifiziert und weiterleitet.

- Dieser Ansatz ist web-skalierbarer, erfordert aber, dass Sie einen öffentlichen Endpunkt bereitstellen.

- Pull-basiert: Ihr Code zieht die neuesten Tickets basierend auf einem gegebenen Zeitplan und leitet sie zum Pull-Zeitpunkt weiter.

- Dieser Ansatz ist einfacher zu implementieren, kann aber unnötige Aufrufe an das Support-Ticket-System machen, wenn die Pull-Frequenz zu hoch ist, oder könnte übermäßig langsam sein, wenn die Pull-Frequenz zu niedrig ist.