Definire se utilizzare Claude per l’instradamento dei ticket

Ecco alcuni indicatori chiave che suggeriscono di utilizzare un LLM come Claude invece degli approcci ML tradizionali per il tuo compito di classificazione:Hai dati di addestramento etichettati limitati disponibili

Hai dati di addestramento etichettati limitati disponibili

Le tue categorie di classificazione probabilmente cambieranno o evolveranno nel tempo

Le tue categorie di classificazione probabilmente cambieranno o evolveranno nel tempo

Devi gestire input di testo complessi e non strutturati

Devi gestire input di testo complessi e non strutturati

Le tue regole di classificazione si basano sulla comprensione semantica

Le tue regole di classificazione si basano sulla comprensione semantica

Richiedi ragionamento interpretabile per le decisioni di classificazione

Richiedi ragionamento interpretabile per le decisioni di classificazione

Vuoi gestire più efficacemente i casi limite e i ticket ambigui

Vuoi gestire più efficacemente i casi limite e i ticket ambigui

Hai bisogno di supporto multilingue senza mantenere modelli separati

Hai bisogno di supporto multilingue senza mantenere modelli separati

Costruire e distribuire il tuo flusso di lavoro di supporto LLM

Comprendere il tuo approccio di supporto attuale

Prima di tuffarsi nell’automazione, è cruciale comprendere il tuo sistema di ticketing esistente. Inizia investigando come il tuo team di supporto attualmente gestisce l’instradamento dei ticket. Considera domande come:- Quali criteri vengono utilizzati per determinare quale SLA/offerta di servizio viene applicata?

- L’instradamento dei ticket viene utilizzato per determinare a quale livello di supporto o specialista del prodotto va un ticket?

- Ci sono regole automatizzate o flussi di lavoro già in atto? In quali casi falliscono?

- Come vengono gestiti i casi limite o i ticket ambigui?

- Come il team prioritizza i ticket?

Definire le categorie di intento dell’utente

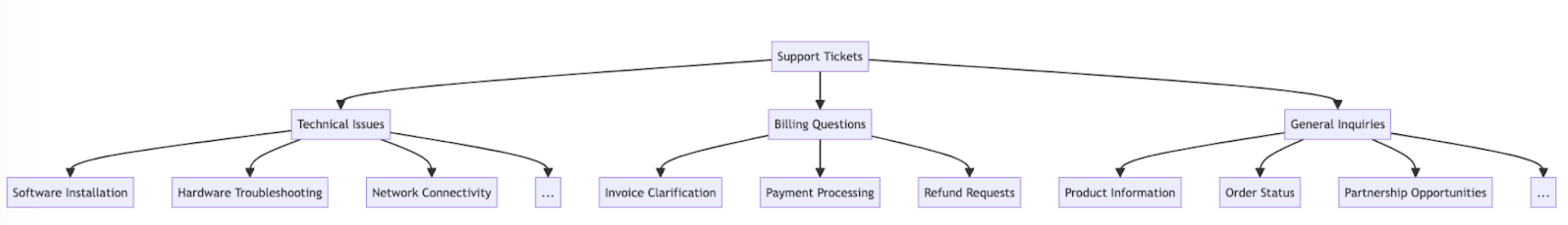

Un elenco ben definito di categorie di intento dell’utente è cruciale per una classificazione accurata dei ticket di supporto con Claude. La capacità di Claude di instradare i ticket efficacemente all’interno del tuo sistema è direttamente proporzionale a quanto ben definite sono le categorie del tuo sistema. Ecco alcune categorie di intento dell’utente di esempio e sottocategorie.Problema tecnico

Problema tecnico

- Problema hardware

- Bug software

- Problema di compatibilità

- Problema di prestazioni

Gestione account

Gestione account

- Reset password

- Problemi di accesso all’account

- Richieste di fatturazione

- Modifiche abbonamento

Informazioni prodotto

Informazioni prodotto

- Richieste di funzionalità

- Domande di compatibilità prodotto

- Informazioni sui prezzi

- Richieste di disponibilità

Guida utente

Guida utente

- Domande how-to

- Assistenza nell’uso delle funzionalità

- Consigli sulle migliori pratiche

- Guida alla risoluzione dei problemi

Feedback

Feedback

- Segnalazioni di bug

- Richieste di funzionalità

- Feedback generale o suggerimenti

- Reclami

Relativo agli ordini

Relativo agli ordini

- Richieste di stato ordine

- Informazioni di spedizione

- Resi e cambi

- Modifiche ordine

Richiesta di servizio

Richiesta di servizio

- Assistenza installazione

- Richieste di aggiornamento

- Programmazione manutenzione

- Cancellazione servizio

Preoccupazioni di sicurezza

Preoccupazioni di sicurezza

- Richieste sulla privacy dei dati

- Segnalazioni di attività sospette

- Assistenza funzionalità di sicurezza

Conformità e legale

Conformità e legale

- Domande sulla conformità normativa

- Richieste sui termini di servizio

- Richieste di documentazione legale

Supporto di emergenza

Supporto di emergenza

- Guasti critici del sistema

- Problemi di sicurezza urgenti

- Problemi sensibili al tempo

Formazione ed educazione

Formazione ed educazione

- Richieste di formazione sul prodotto

- Richieste di documentazione

- Informazioni su webinar o workshop

Integrazione e API

Integrazione e API

- Assistenza integrazione

- Domande sull’uso delle API

- Richieste di compatibilità con terze parti

Stabilire criteri di successo

Lavora con il tuo team di supporto per definire criteri di successo chiari con benchmark misurabili, soglie e obiettivi. Ecco alcuni criteri standard e benchmark quando si utilizzano LLM per l’instradamento dei ticket di supporto:Coerenza di classificazione

Coerenza di classificazione

Velocità di adattamento

Velocità di adattamento

Gestione multilingue

Gestione multilingue

Gestione dei casi limite

Gestione dei casi limite

Mitigazione dei bias

Mitigazione dei bias

Efficienza del prompt

Efficienza del prompt

Punteggio di spiegabilità

Punteggio di spiegabilità

Accuratezza dell'instradamento

Accuratezza dell'instradamento

Tempo di assegnazione

Tempo di assegnazione

Tasso di re-instradamento

Tasso di re-instradamento

Tasso di risoluzione al primo contatto

Tasso di risoluzione al primo contatto

Tempo medio di gestione

Tempo medio di gestione

Punteggi di soddisfazione del cliente

Punteggi di soddisfazione del cliente

Tasso di escalation

Tasso di escalation

Produttività dell'agente

Produttività dell'agente

Tasso di deflection self-service

Tasso di deflection self-service

Costo per ticket

Costo per ticket

Scegliere il modello Claude giusto

La scelta del modello dipende dai compromessi tra costo, accuratezza e tempo di risposta. Molti clienti hanno trovatoclaude-3-5-haiku-20241022 un modello ideale per l’instradamento dei ticket, poiché è il modello più veloce e conveniente nella famiglia Claude 3 pur fornendo ancora risultati eccellenti. Se il tuo problema di classificazione richiede una profonda expertise in materia o un grande volume di categorie di intento con ragionamento complesso, potresti optare per il modello Sonnet più grande.

Costruire un prompt forte

L’instradamento dei ticket è un tipo di compito di classificazione. Claude analizza il contenuto di un ticket di supporto e lo classifica in categorie predefinite basate sul tipo di problema, urgenza, expertise richiesta o altri fattori rilevanti. Scriviamo un prompt di classificazione dei ticket. Il nostro prompt iniziale dovrebbe contenere i contenuti della richiesta dell’utente e restituire sia il ragionamento che l’intento.- Utilizziamo le f-string di Python per creare il template del prompt, permettendo al

ticket_contentsdi essere inserito nei tag<request>. - Diamo a Claude un ruolo chiaramente definito come sistema di classificazione che analizza attentamente il contenuto del ticket per determinare l’intento principale e le esigenze del cliente.

- Istruiamo Claude sulla formattazione corretta dell’output, in questo caso per fornire il suo ragionamento e analisi all’interno dei tag

<reasoning>, seguito dall’etichetta di classificazione appropriata all’interno dei tag<intent>. - Specifichiamo le categorie di intento valide: “Support, Feedback, Complaint”, “Order Tracking” e “Refund/Exchange”.

- Includiamo alcuni esempi (a.k.a. few-shot prompting) per illustrare come dovrebbe essere formattato l’output, il che migliora accuratezza e coerenza.

Distribuire il tuo prompt

È difficile sapere quanto bene funziona il tuo prompt senza distribuirlo in un ambiente di produzione di test e eseguire valutazioni. Costruiamo la struttura di distribuzione. Inizia definendo la firma del metodo per avvolgere la nostra chiamata a Claude. Prenderemo il metodo che abbiamo già iniziato a scrivere, che haticket_contents come input, e ora restituiremo una tupla di reasoning e intent come output. Se hai un’automazione esistente che utilizza ML tradizionale, vorrai seguire quella firma del metodo invece.

- Importa la libreria Anthropic e crea un’istanza client utilizzando la tua chiave API.

- Definisce una funzione

classify_support_requestche prende una stringaticket_contents. - Invia il

ticket_contentsa Claude per la classificazione utilizzando ilclassification_prompt - Restituisce il

reasoninge l’intentdel modello estratti dalla risposta.

stream=False (il default).

Valutare il tuo prompt

Il prompting spesso richiede test e ottimizzazione per essere pronto per la produzione. Per determinare la prontezza della tua soluzione, valuta le prestazioni basandoti sui criteri di successo e le soglie che hai stabilito in precedenza. Per eseguire la tua valutazione, avrai bisogno di casi di test su cui eseguirla. Il resto di questa guida assume che tu abbia già sviluppato i tuoi casi di test.Costruire una funzione di valutazione

La nostra valutazione di esempio per questa guida misura le prestazioni di Claude lungo tre metriche chiave:- Accuratezza

- Costo per classificazione

- Abbiamo aggiunto l’

actual_intentdai nostri casi di test nel metodoclassify_support_requeste impostato un confronto per valutare se la classificazione dell’intento di Claude corrisponde alla nostra classificazione dell’intento golden. - Abbiamo estratto le statistiche di utilizzo per la chiamata API per calcolare il costo basato sui token di input e output utilizzati

Eseguire la tua valutazione

Una valutazione appropriata richiede soglie e benchmark chiari per determinare cosa è un buon risultato. Lo script sopra ci darà i valori runtime per accuratezza, tempo di risposta e costo per classificazione, ma avremmo ancora bisogno di soglie chiaramente stabilite. Per esempio:- Accuratezza: 95% (su 100 test)

- Costo per classificazione: 50% di riduzione in media (su 100 test) dal metodo di instradamento attuale

Migliorare le prestazioni

In scenari complessi, può essere utile considerare strategie aggiuntive per migliorare le prestazioni oltre alle tecniche standard di ingegneria dei prompt e alle strategie di implementazione dei guardrail. Ecco alcuni scenari comuni:Utilizzare una gerarchia tassonomica per casi con 20+ categorie di intento

Man mano che il numero di classi cresce, il numero di esempi richiesti si espande anche, rendendo potenzialmente il prompt ingombrante. Come alternativa, puoi considerare l’implementazione di un sistema di classificazione gerarchico utilizzando una miscela di classificatori.- Organizza i tuoi intenti in una struttura ad albero tassonomico.

- Crea una serie di classificatori ad ogni livello dell’albero, abilitando un approccio di instradamento a cascata.

- Pro - maggiore sfumatura e accuratezza: Puoi creare prompt diversi per ogni percorso genitore, permettendo una classificazione più mirata e specifica per il contesto. Questo può portare a una migliore accuratezza e gestione più sfumata delle richieste dei clienti.

- Contro - latenza aumentata: Tieni presente che classificatori multipli possono portare a una latenza aumentata, e raccomandiamo di implementare questo approccio con il nostro modello più veloce, Haiku.

Utilizzare database vettoriali e ricerca di similarità per gestire ticket altamente variabili

Nonostante fornire esempi sia il modo più efficace per migliorare le prestazioni, se le richieste di supporto sono altamente variabili, può essere difficile includere abbastanza esempi in un singolo prompt. In questo scenario, potresti impiegare un database vettoriale per fare ricerche di similarità da un dataset di esempi e recuperare gli esempi più rilevanti per una data query. Questo approccio, delineato in dettaglio nella nostra ricetta di classificazione, ha dimostrato di migliorare le prestazioni dal 71% di accuratezza al 93% di accuratezza.Tenere conto specificamente dei casi limite previsti

Ecco alcuni scenari dove Claude potrebbe classificare erroneamente i ticket (potrebbero essercene altri che sono unici alla tua situazione). In questi scenari, considera di fornire istruzioni esplicite o esempi nel prompt di come Claude dovrebbe gestire il caso limite:I clienti fanno richieste implicite

I clienti fanno richieste implicite

- Soluzione: Fornisci a Claude alcuni esempi reali di clienti di questi tipi di richieste, insieme a quale sia l’intento sottostante. Puoi ottenere risultati ancora migliori se includi una logica di classificazione per intenti di ticket particolarmente sfumati, così che Claude possa generalizzare meglio la logica ad altri ticket.

Claude prioritizza l'emozione sull'intento

Claude prioritizza l'emozione sull'intento

- Soluzione: Fornisci a Claude indicazioni su quando prioritizzare il sentimento del cliente o no. Può essere qualcosa di semplice come “Ignora tutte le emozioni del cliente. Concentrati solo sull’analizzare l’intento della richiesta del cliente e quali informazioni il cliente potrebbe star chiedendo.”

Problemi multipli causano confusione nella prioritizzazione dei problemi

Problemi multipli causano confusione nella prioritizzazione dei problemi

- Soluzione: Chiarisci la prioritizzazione degli intenti così che Claude possa meglio classificare gli intenti estratti e identificare la preoccupazione primaria.

Integrare Claude nel tuo flusso di lavoro di supporto più ampio

Un’integrazione appropriata richiede che tu prenda alcune decisioni riguardo a come il tuo script di instradamento dei ticket basato su Claude si inserisce nell’architettura del tuo sistema di instradamento dei ticket più ampio. Ci sono due modi in cui potresti farlo:- Basato su push: Il sistema di ticket di supporto che stai utilizzando (es. Zendesk) attiva il tuo codice inviando un evento webhook al tuo servizio di instradamento, che poi classifica l’intento e lo instrада.

- Questo approccio è più scalabile per il web, ma ha bisogno che tu esponga un endpoint pubblico.

- Basato su pull: Il tuo codice tira per gli ultimi ticket basandosi su una data programmazione e li instrада al momento del pull.

- Questo approccio è più facile da implementare ma potrebbe fare chiamate non necessarie al sistema di ticket di supporto quando la frequenza di pull è troppo alta o potrebbe essere eccessivamente lento quando la frequenza di pull è troppo bassa.