Definir se deve usar o Claude para roteamento de tickets

Aqui estão alguns indicadores-chave de que você deve usar um LLM como o Claude em vez de abordagens tradicionais de ML para sua tarefa de classificação:Você tem dados de treinamento rotulados limitados disponíveis

Você tem dados de treinamento rotulados limitados disponíveis

Suas categorias de classificação provavelmente mudarão ou evoluirão ao longo do tempo

Suas categorias de classificação provavelmente mudarão ou evoluirão ao longo do tempo

Você precisa lidar com entradas de texto complexas e não estruturadas

Você precisa lidar com entradas de texto complexas e não estruturadas

Suas regras de classificação são baseadas em compreensão semântica

Suas regras de classificação são baseadas em compreensão semântica

Você requer raciocínio interpretável para decisões de classificação

Você requer raciocínio interpretável para decisões de classificação

Você quer lidar com casos extremos e tickets ambíguos de forma mais eficaz

Você quer lidar com casos extremos e tickets ambíguos de forma mais eficaz

Você precisa de suporte multilíngue sem manter modelos separados

Você precisa de suporte multilíngue sem manter modelos separados

Construir e implantar seu fluxo de trabalho de suporte LLM

Compreender sua abordagem de suporte atual

Antes de mergulhar na automação, é crucial compreender seu sistema de tickets existente. Comece investigando como sua equipe de suporte atualmente lida com o roteamento de tickets. Considere perguntas como:- Quais critérios são usados para determinar qual SLA/oferta de serviço é aplicada?

- O roteamento de tickets é usado para determinar para qual nível de suporte ou especialista de produto um ticket vai?

- Existem regras ou fluxos de trabalho automatizados já em vigor? Em quais casos eles falham?

- Como casos extremos ou tickets ambíguos são tratados?

- Como a equipe prioriza tickets?

Definir categorias de intenção do usuário

Uma lista bem definida de categorias de intenção do usuário é crucial para classificação precisa de tickets de suporte com o Claude. A capacidade do Claude de rotear tickets efetivamente dentro do seu sistema é diretamente proporcional a quão bem definidas suas categorias do sistema são. Aqui estão algumas categorias de intenção do usuário e subcategorias de exemplo.Problema técnico

Problema técnico

- Problema de hardware

- Bug de software

- Problema de compatibilidade

- Problema de desempenho

Gerenciamento de conta

Gerenciamento de conta

- Redefinição de senha

- Problemas de acesso à conta

- Consultas de cobrança

- Mudanças de assinatura

Informações do produto

Informações do produto

- Consultas sobre recursos

- Perguntas sobre compatibilidade do produto

- Informações de preços

- Consultas de disponibilidade

Orientação do usuário

Orientação do usuário

- Perguntas de como fazer

- Assistência de uso de recursos

- Conselhos de melhores práticas

- Orientação de solução de problemas

Feedback

Feedback

- Relatórios de bugs

- Solicitações de recursos

- Feedback geral ou sugestões

- Reclamações

Relacionado a pedidos

Relacionado a pedidos

- Consultas de status de pedido

- Informações de envio

- Devoluções e trocas

- Modificações de pedido

Solicitação de serviço

Solicitação de serviço

- Assistência de instalação

- Solicitações de upgrade

- Agendamento de manutenção

- Cancelamento de serviço

Preocupações de segurança

Preocupações de segurança

- Consultas de privacidade de dados

- Relatórios de atividade suspeita

- Assistência de recursos de segurança

Conformidade e legal

Conformidade e legal

- Perguntas de conformidade regulatória

- Consultas de termos de serviço

- Solicitações de documentação legal

Suporte de emergência

Suporte de emergência

- Falhas críticas do sistema

- Problemas urgentes de segurança

- Problemas sensíveis ao tempo

Treinamento e educação

Treinamento e educação

- Solicitações de treinamento do produto

- Consultas de documentação

- Informações de webinar ou workshop

Integração e API

Integração e API

- Assistência de integração

- Perguntas de uso de API

- Consultas de compatibilidade de terceiros

Estabelecer critérios de sucesso

Trabalhe com sua equipe de suporte para definir critérios de sucesso claros com benchmarks mensuráveis, limites e objetivos. Aqui estão alguns critérios padrão e benchmarks ao usar LLMs para roteamento de tickets de suporte:Consistência de classificação

Consistência de classificação

Velocidade de adaptação

Velocidade de adaptação

Manuseio multilíngue

Manuseio multilíngue

Manuseio de casos extremos

Manuseio de casos extremos

Mitigação de viés

Mitigação de viés

Eficiência de prompt

Eficiência de prompt

Pontuação de explicabilidade

Pontuação de explicabilidade

Precisão de roteamento

Precisão de roteamento

Tempo para atribuição

Tempo para atribuição

Taxa de reroteamento

Taxa de reroteamento

Taxa de resolução no primeiro contato

Taxa de resolução no primeiro contato

Tempo médio de manuseio

Tempo médio de manuseio

Pontuações de satisfação do cliente

Pontuações de satisfação do cliente

Taxa de escalação

Taxa de escalação

Produtividade do agente

Produtividade do agente

Taxa de deflexão de autoatendimento

Taxa de deflexão de autoatendimento

Custo por ticket

Custo por ticket

Escolher o modelo Claude certo

A escolha do modelo depende dos trade-offs entre custo, precisão e tempo de resposta. Muitos clientes descobriram que oclaude-3-5-haiku-20241022 é um modelo ideal para roteamento de tickets, pois é o modelo mais rápido e mais econômico na família Claude 3 enquanto ainda entrega resultados excelentes. Se seu problema de classificação requer expertise profunda em assunto ou um grande volume de categorias de intenção com raciocínio complexo, você pode optar pelo modelo Sonnet maior.

Construir um prompt forte

Roteamento de tickets é um tipo de tarefa de classificação. O Claude analisa o conteúdo de um ticket de suporte e o classifica em categorias predefinidas baseadas no tipo de problema, urgência, expertise necessária ou outros fatores relevantes. Vamos escrever um prompt de classificação de tickets. Nosso prompt inicial deve conter o conteúdo da solicitação do usuário e retornar tanto o raciocínio quanto a intenção.- Usamos f-strings do Python para criar o template do prompt, permitindo que o

ticket_contentsseja inserido nas tags<request>. - Damos ao Claude um papel claramente definido como um sistema de classificação que analisa cuidadosamente o conteúdo do ticket para determinar a intenção central e necessidades do cliente.

- Instruímos o Claude sobre formatação de saída adequada, neste caso para fornecer seu raciocínio e análise dentro de tags

<reasoning>, seguido pelo rótulo de classificação apropriado dentro de tags<intent>. - Especificamos as categorias de intenção válidas: “Suporte, Feedback, Reclamação”, “Rastreamento de Pedido” e “Reembolso/Troca”.

- Incluímos alguns exemplos (também conhecido como prompting few-shot) para ilustrar como a saída deve ser formatada, o que melhora a precisão e consistência.

Implantar seu prompt

É difícil saber quão bem seu prompt funciona sem implantá-lo em um ambiente de produção de teste e executar avaliações. Vamos construir a estrutura de implantação. Comece definindo a assinatura do método para envolver nossa chamada ao Claude. Pegaremos o método que já começamos a escrever, que temticket_contents como entrada, e agora retornará uma tupla de reasoning e intent como saída. Se você tem uma automação existente usando ML tradicional, você vai querer seguir essa assinatura de método em vez disso.

- Importa a biblioteca Anthropic e cria uma instância de cliente usando sua chave API.

- Define uma função

classify_support_requestque recebe uma stringticket_contents. - Envia o

ticket_contentspara o Claude para classificação usando oclassification_prompt - Retorna o

reasoningeintentdo modelo extraídos da resposta.

stream=False (o padrão).

Avaliar seu prompt

Prompting frequentemente requer testes e otimização para estar pronto para produção. Para determinar a prontidão de sua solução, avalie o desempenho baseado nos critérios de sucesso e limites que você estabeleceu anteriormente. Para executar sua avaliação, você precisará de casos de teste para executá-la. O resto deste guia assume que você já desenvolveu seus casos de teste.Construir uma função de avaliação

Nossa avaliação de exemplo para este guia mede o desempenho do Claude ao longo de três métricas-chave:- Precisão

- Custo por classificação

- Adicionamos o

actual_intentde nossos casos de teste no métodoclassify_support_requeste configuramos uma comparação para avaliar se a classificação de intenção do Claude corresponde à nossa classificação de intenção dourada. - Extraímos estatísticas de uso para a chamada da API para calcular o custo baseado em tokens de entrada e saída usados

Executar sua avaliação

Uma avaliação adequada requer limites e benchmarks claros para determinar o que é um bom resultado. O script acima nos dará os valores de tempo de execução para precisão, tempo de resposta e custo por classificação, mas ainda precisaríamos de limites claramente estabelecidos. Por exemplo:- Precisão: 95% (de 100 testes)

- Custo por classificação: 50% de redução em média (através de 100 testes) do método de roteamento atual

Melhorar o desempenho

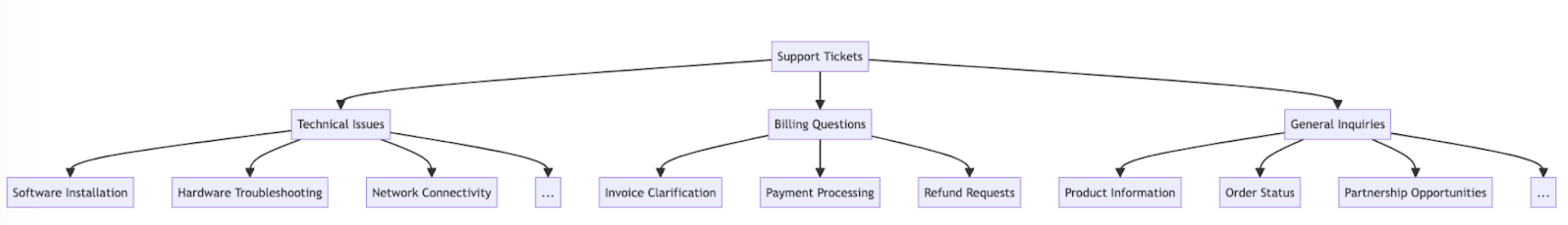

Em cenários complexos, pode ser útil considerar estratégias adicionais para melhorar o desempenho além das técnicas padrão de engenharia de prompt e estratégias de implementação de guardrails. Aqui estão alguns cenários comuns:Usar uma hierarquia taxonômica para casos com 20+ categorias de intenção

Conforme o número de classes cresce, o número de exemplos necessários também se expande, potencialmente tornando o prompt pesado. Como alternativa, você pode considerar implementar um sistema de classificação hierárquica usando uma mistura de classificadores.- Organize suas intenções em uma estrutura de árvore taxonômica.

- Crie uma série de classificadores em cada nível da árvore, permitindo uma abordagem de roteamento em cascata.

- Prós - maior nuance e precisão: Você pode criar prompts diferentes para cada caminho pai, permitindo classificação mais direcionada e específica ao contexto. Isso pode levar a precisão melhorada e manuseio mais nuançado de solicitações de clientes.

- Contras - latência aumentada: Esteja ciente de que múltiplos classificadores podem levar a latência aumentada, e recomendamos implementar essa abordagem com nosso modelo mais rápido, Haiku.

Usar bancos de dados vetoriais e recuperação de busca por similaridade para lidar com tickets altamente variáveis

Apesar de fornecer exemplos ser a maneira mais eficaz de melhorar o desempenho, se solicitações de suporte são altamente variáveis, pode ser difícil incluir exemplos suficientes em um único prompt. Neste cenário, você poderia empregar um banco de dados vetorial para fazer buscas de similaridade de um conjunto de dados de exemplos e recuperar os exemplos mais relevantes para uma consulta dada. Esta abordagem, delineada em detalhes em nossa receita de classificação, foi mostrada para melhorar o desempenho de 71% de precisão para 93% de precisão.Considerar especificamente casos extremos esperados

Aqui estão alguns cenários onde o Claude pode classificar incorretamente tickets (pode haver outros que são únicos à sua situação). Nestes cenários, considere fornecer instruções explícitas ou exemplos no prompt de como o Claude deve lidar com o caso extremo:Clientes fazem solicitações implícitas

Clientes fazem solicitações implícitas

- Solução: Forneça ao Claude alguns exemplos reais de clientes desses tipos de solicitações, junto com qual é a intenção subjacente. Você pode obter resultados ainda melhores se incluir uma justificativa de classificação para intenções de tickets particularmente nuançadas, para que o Claude possa generalizar melhor a lógica para outros tickets.

Claude prioriza emoção sobre intenção

Claude prioriza emoção sobre intenção

- Solução: Forneça ao Claude direções sobre quando priorizar sentimento do cliente ou não. Pode ser algo tão simples quanto “Ignore todas as emoções do cliente. Foque apenas em analisar a intenção da solicitação do cliente e que informações o cliente pode estar pedindo.”

Múltiplos problemas causam confusão de priorização de problemas

Múltiplos problemas causam confusão de priorização de problemas

- Solução: Esclareça a priorização de intenções para que o Claude possa melhor classificar as intenções extraídas e identificar a preocupação primária.

Integrar o Claude em seu fluxo de trabalho de suporte maior

Integração adequada requer que você tome algumas decisões sobre como seu script de roteamento de tickets baseado no Claude se encaixa na arquitetura do seu sistema maior de roteamento de tickets. Há duas maneiras de fazer isso:- Baseado em push: O sistema de tickets de suporte que você está usando (ex: Zendesk) aciona seu código enviando um evento webhook para seu serviço de roteamento, que então classifica a intenção e a roteia.

- Esta abordagem é mais escalável na web, mas precisa que você exponha um endpoint público.

- Baseado em pull: Seu código puxa pelos tickets mais recentes baseado em um cronograma dado e os roteia no momento do pull.

- Esta abordagem é mais fácil de implementar mas pode fazer chamadas desnecessárias ao sistema de tickets de suporte quando a frequência de pull é muito alta ou pode ser excessivamente lenta quando a frequência de pull é muito baixa.