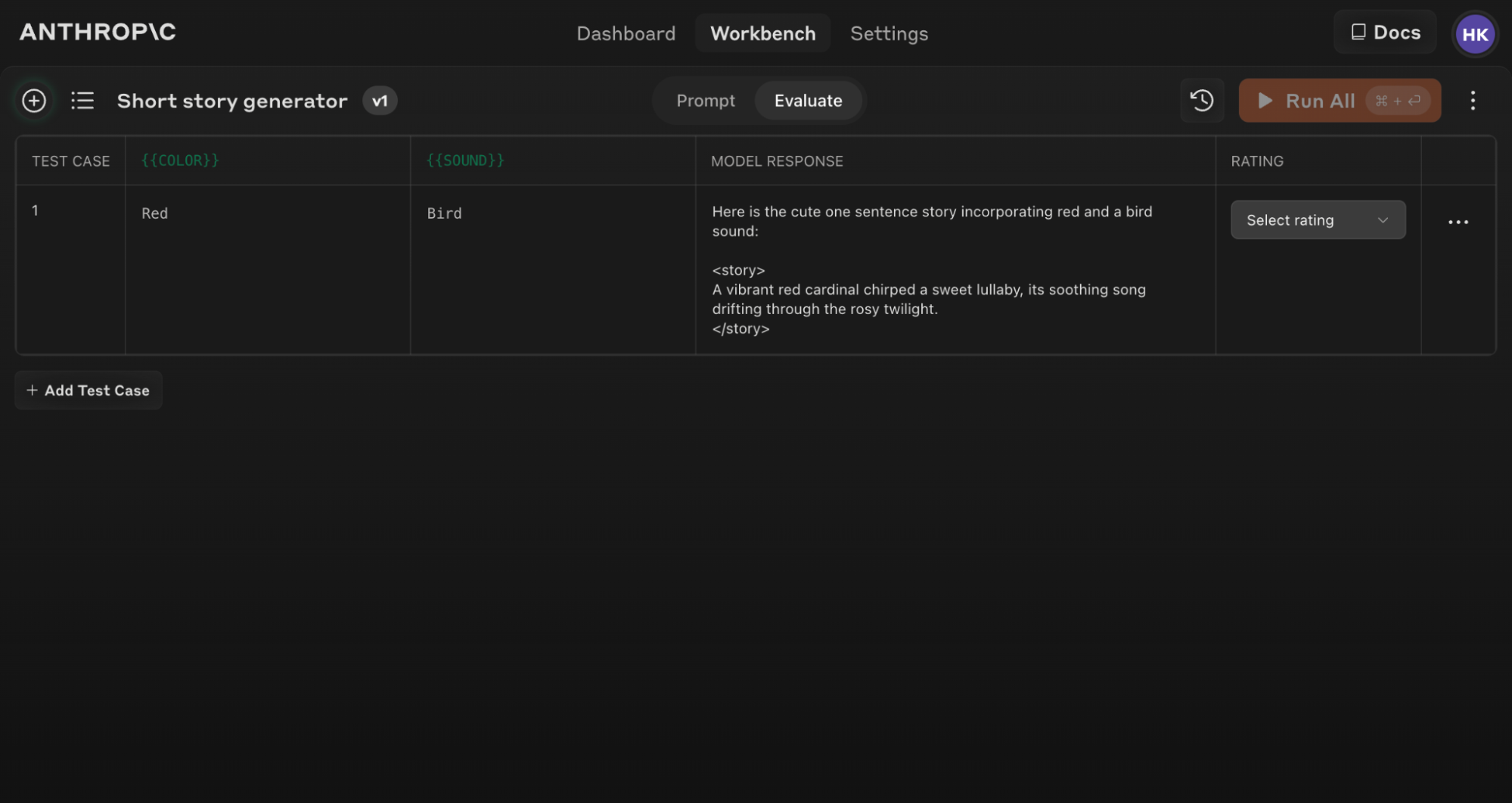

存取評估功能

要開始使用評估工具:- 開啟 Claude Console 並導航到提示編輯器。

- 撰寫完提示後,在螢幕頂部尋找「評估」標籤。

確保您的提示包含至少 1-2 個使用雙大括號語法的動態變數:{{variable}}。這是建立評估測試集的必要條件。

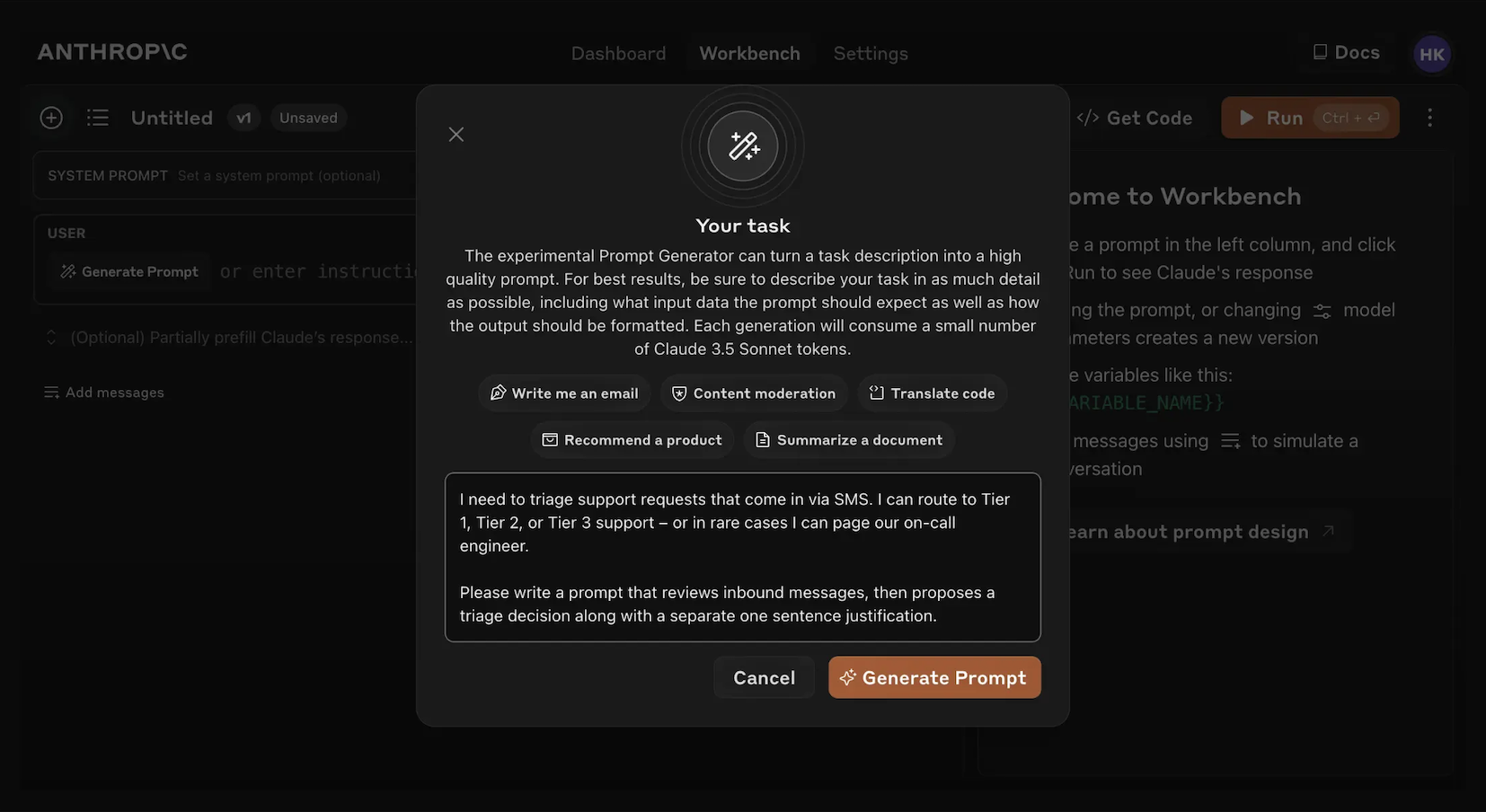

生成提示

Console 提供內建的 提示生成器,由 Claude Opus 4.1 驅動:1

點擊「生成提示」

點擊「生成提示」輔助工具將開啟一個模態視窗,讓您輸入任務資訊。

2

描述您的任務

描述您想要的任務(例如,「分類入站客戶支援請求」),可以提供詳細或簡略的描述。您提供的上下文越多,Claude 就越能針對您的特定需求量身定制生成的提示。

3

生成您的提示

點擊底部的橙色「生成提示」按鈕,Claude 將為您生成高品質的提示。然後您可以使用 Console 中的評估螢幕進一步改善這些提示。

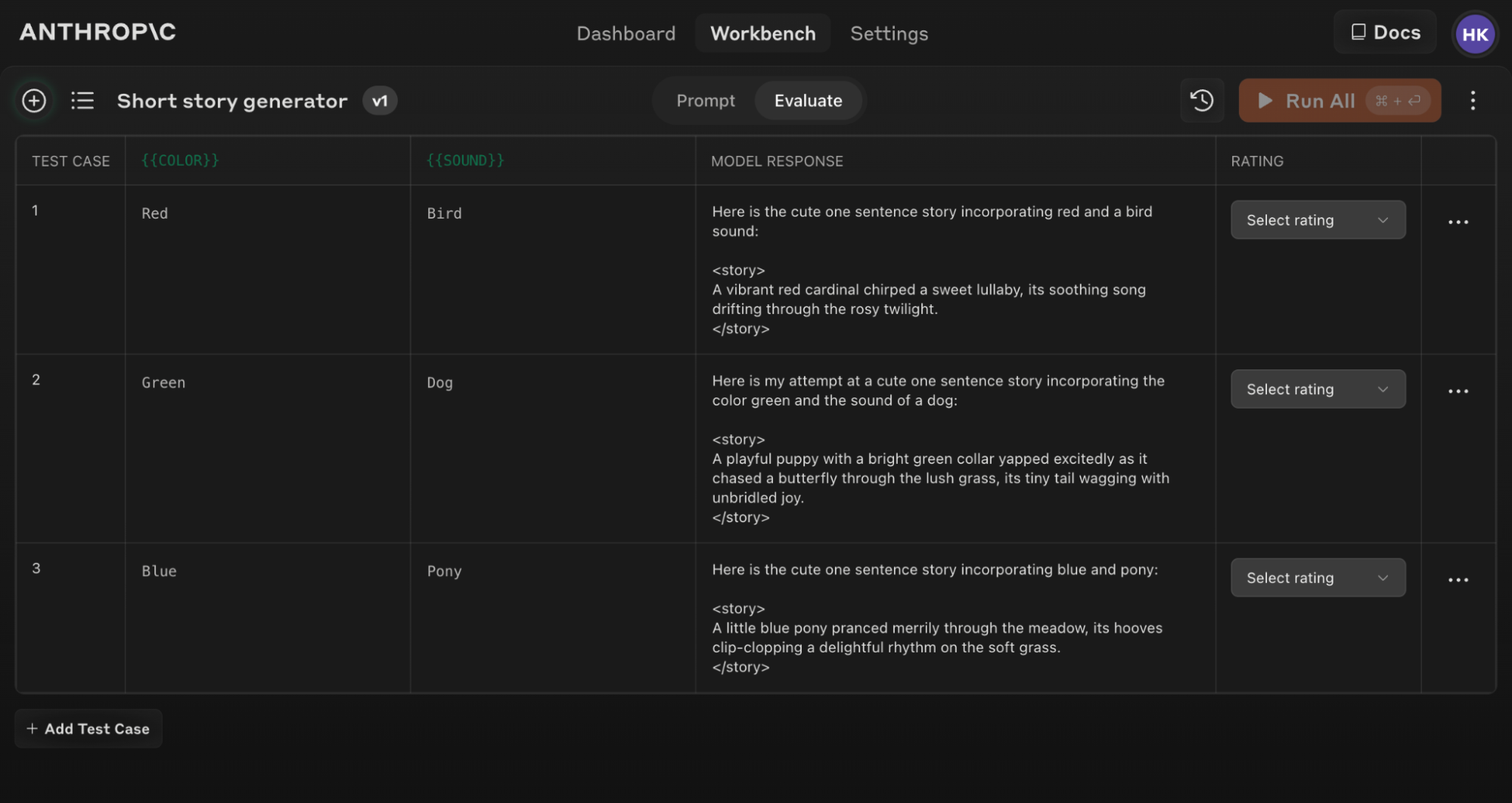

建立測試案例

當您存取評估螢幕時,您有幾個選項來建立測試案例:- 點擊左下角的「+ 新增行」按鈕手動新增案例。

- 使用「生成測試案例」功能讓 Claude 自動為您生成測試案例。

- 從 CSV 檔案匯入測試案例。

1

點擊「生成測試案例」

Claude 將為您生成測試案例,每次點擊按鈕時一次生成一行。

2

編輯生成邏輯(可選)

您也可以透過點擊「生成測試案例」按鈕右側的箭頭下拉選單,然後點擊彈出的變數視窗頂部的「顯示生成邏輯」來編輯測試案例生成邏輯。您可能需要點擊此視窗右上角的「生成」來填入初始生成邏輯。編輯此項目可讓您自訂和微調 Claude 生成的測試案例,以獲得更高的精確度和特異性。

如果您更新原始提示文字,您可以對新提示重新執行整個評估套件,以查看變更如何影響所有測試案例的效能。

有效評估的技巧

評估的提示結構

評估的提示結構

要充分利用評估工具,請使用清晰的輸入和輸出格式來構建您的提示。例如:這種結構讓您可以輕鬆變化輸入({{COLOR}} 和 {{SOUND}})並一致地評估輸出。

使用 Console 中的「生成提示」輔助工具快速建立具有適當變數語法的提示以進行評估。

理解和比較結果

評估工具提供多項功能來幫助您改善提示:- 並排比較:比較兩個或多個提示的輸出,快速查看您的變更所產生的影響。

- 品質評分:使用 5 分制對回應品質進行評分,以追蹤每個提示的回應品質改善情況。

- 提示版本控制:建立提示的新版本並重新執行測試套件,以快速迭代和改善結果。