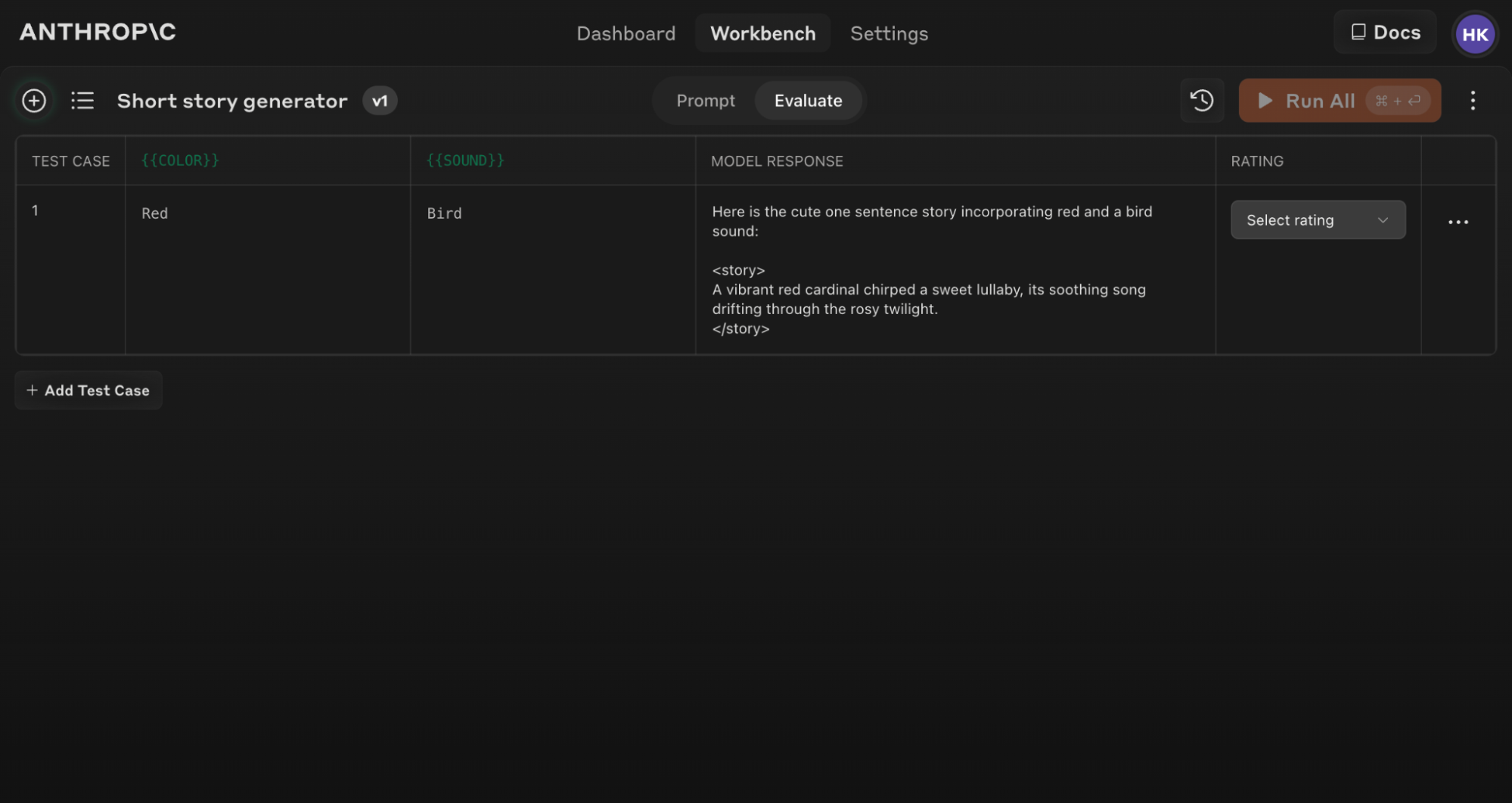

Accès à la fonctionnalité d’évaluation

Pour commencer avec l’outil d’évaluation :- Ouvrez la Console Claude et naviguez vers l’éditeur de prompts.

- Après avoir composé votre prompt, recherchez l’onglet ‘Evaluate’ en haut de l’écran.

Assurez-vous que votre prompt inclut au moins 1-2 variables dynamiques en utilisant la syntaxe à double accolades : {{variable}}. Ceci est requis pour créer des ensembles de tests d’évaluation.

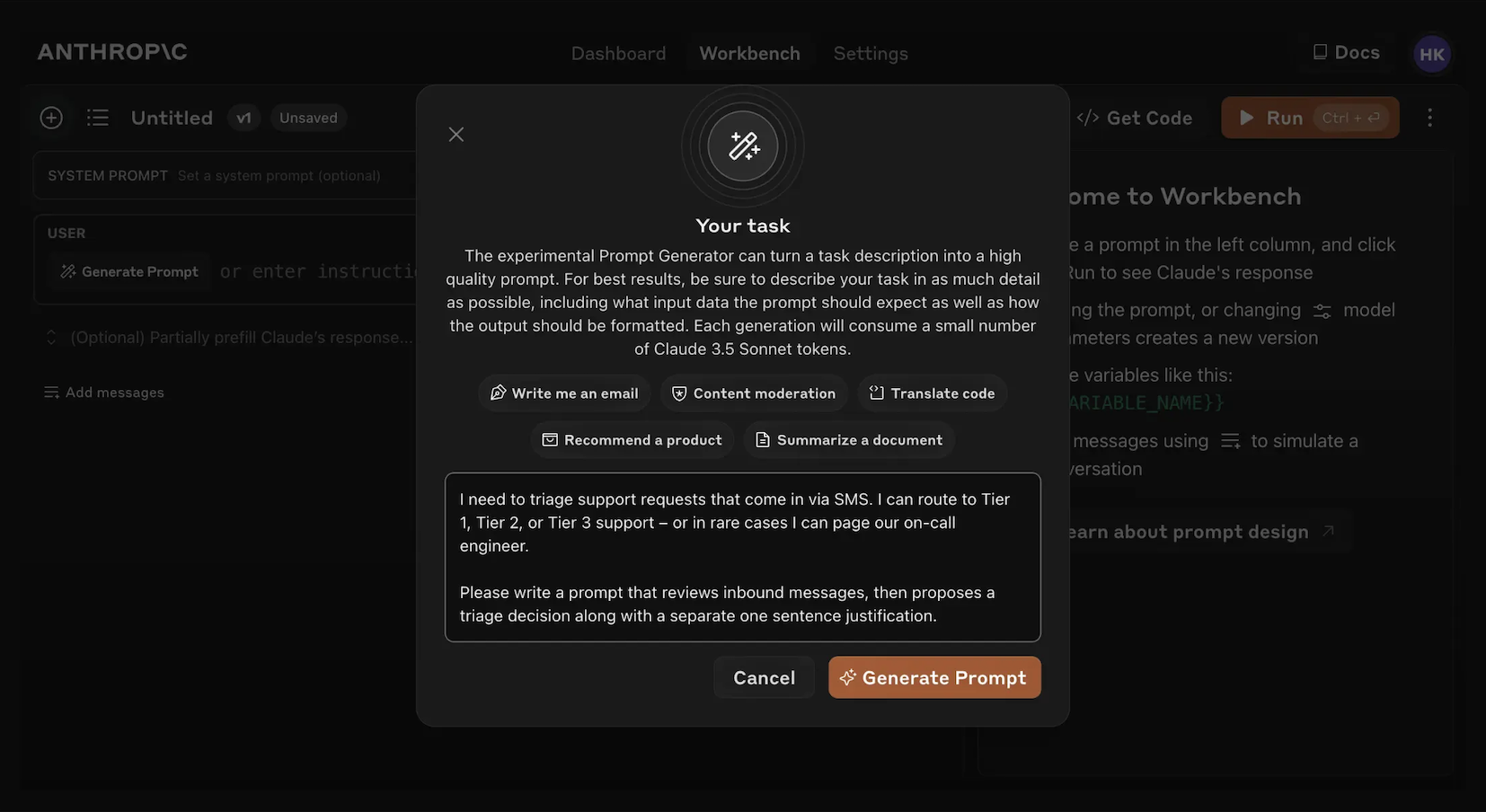

Génération de prompts

La Console offre un générateur de prompts intégré alimenté par Claude Opus 4.1 :1

Cliquez sur 'Generate Prompt'

Cliquer sur l’outil d’aide ‘Generate Prompt’ ouvrira une fenêtre modale qui vous permet de saisir les informations de votre tâche.

2

Décrivez votre tâche

Décrivez votre tâche souhaitée (par exemple, “Trier les demandes de support client entrant”) avec autant ou aussi peu de détails que vous le souhaitez. Plus vous incluez de contexte, plus Claude peut adapter son prompt généré à vos besoins spécifiques.

3

Générez votre prompt

Cliquer sur le bouton orange ‘Generate Prompt’ en bas fera que Claude génère un prompt de haute qualité pour vous. Vous pouvez ensuite améliorer davantage ces prompts en utilisant l’écran d’évaluation dans la Console.

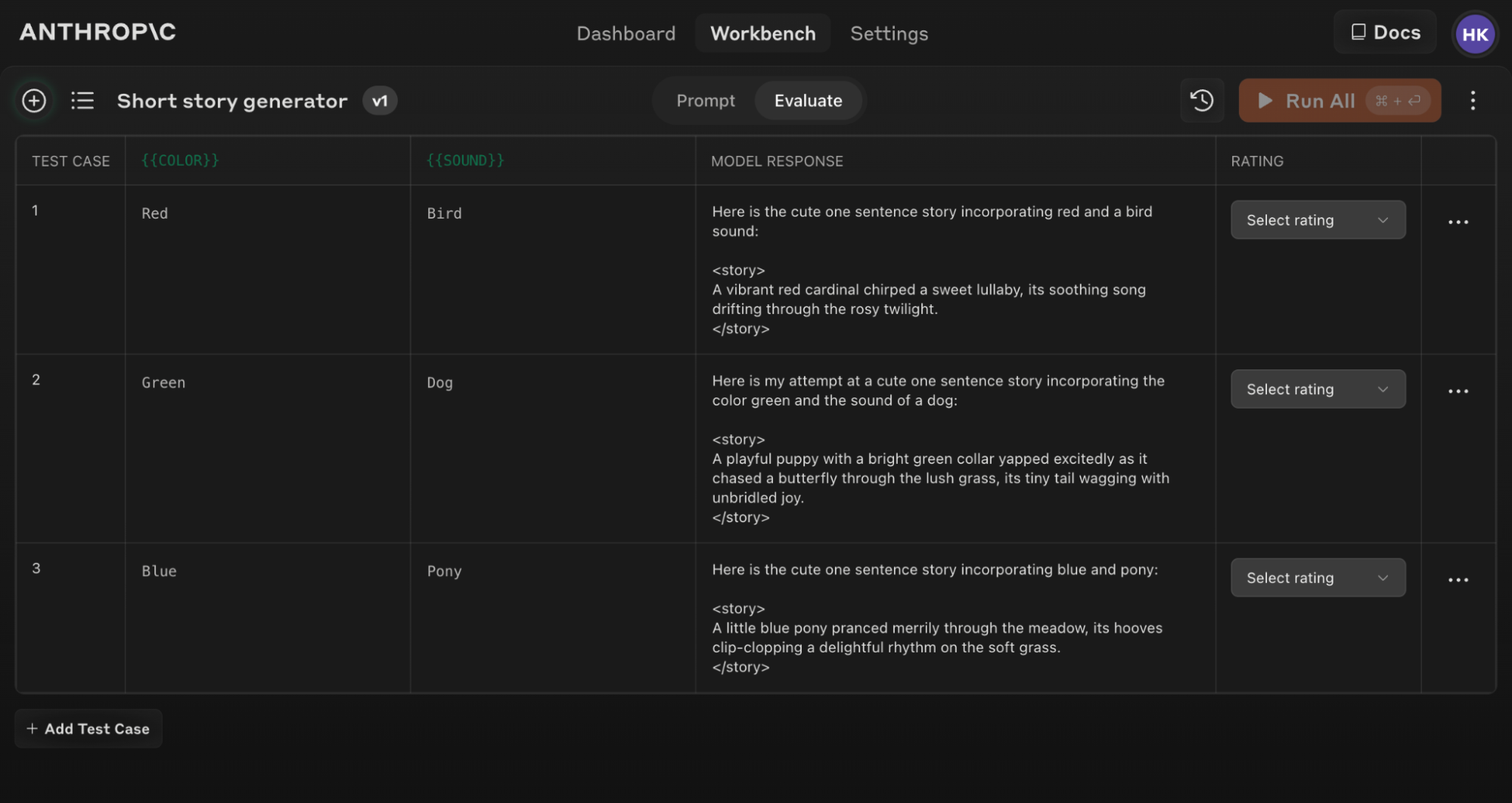

Création de cas de test

Lorsque vous accédez à l’écran d’évaluation, vous avez plusieurs options pour créer des cas de test :- Cliquez sur le bouton ’+ Add Row’ en bas à gauche pour ajouter manuellement un cas.

- Utilisez la fonctionnalité ‘Generate Test Case’ pour que Claude génère automatiquement des cas de test pour vous.

- Importez des cas de test à partir d’un fichier CSV.

1

Cliquez sur 'Generate Test Case'

Claude générera des cas de test pour vous, une ligne à la fois pour chaque fois que vous cliquez sur le bouton.

2

Modifiez la logique de génération (optionnel)

Vous pouvez également modifier la logique de génération de cas de test en cliquant sur la flèche déroulante à droite du bouton ‘Generate Test Case’, puis sur ‘Show generation logic’ en haut de la fenêtre Variables qui apparaît. Vous devrez peut-être cliquer sur `Generate’ en haut à droite de cette fenêtre pour remplir la logique de génération initiale.Modifier ceci vous permet de personnaliser et d’affiner les cas de test que Claude génère avec une plus grande précision et spécificité.

Si vous mettez à jour votre texte de prompt original, vous pouvez relancer toute la suite d’évaluation contre le nouveau prompt pour voir comment les changements affectent les performances sur tous les cas de test.

Conseils pour une évaluation efficace

Structure de prompt pour l'évaluation

Structure de prompt pour l'évaluation

Pour tirer le meilleur parti de l’outil d’évaluation, structurez vos prompts avec des formats d’entrée et de sortie clairs. Par exemple :Cette structure facilite la variation des entrées ({{COLOR}} et {{SOUND}}) et l’évaluation cohérente des sorties.

Utilisez l’outil d’aide ‘Generate a prompt’ dans la Console pour créer rapidement des prompts avec la syntaxe de variable appropriée pour l’évaluation.

Comprendre et comparer les résultats

L’outil d’évaluation offre plusieurs fonctionnalités pour vous aider à affiner vos prompts :- Comparaison côte à côte : Comparez les sorties de deux ou plusieurs prompts pour voir rapidement l’impact de vos changements.

- Notation de qualité : Notez la qualité des réponses sur une échelle de 5 points pour suivre les améliorations de la qualité des réponses par prompt.

- Versioning de prompts : Créez de nouvelles versions de votre prompt et relancez la suite de tests pour itérer rapidement et améliorer les résultats.